五家大厂边缘AI芯片解决方案

随着围绕生成式人工智能的炒作对数据中心强大芯片产生了新的需求,随着组织计划在需要边缘人工智能处理能力的物联网部署上花费更多资金,对更小、更高效芯片的需求仍然强劲。

本文引用地址://www.cghlg.com/article/202310/451219.htm研究公司 Gartner 表示,边缘基础设施和端点设备中基于人工智能的应用程序的使用增加是其估计今年人工智能芯片收入将增长 20.9% 至 534 亿美元的重要推动因素。预计 2024 年销售额将进一步增长 25.6%,达到 671 亿美元。

对于大量联网的物联网设备,在边缘处理人工智能工作负载比云端更好,除了可以大幅削减数据传输和处理成本并确保数据隐私和安全之外,还可以提供近乎实时的推理和响应时间,高级员工全球咨询公司德勤最近在《华尔街日报》发表的一篇文章中写道。「通过将云的可扩展和弹性计算能力分布在更靠近设备和用户在物理世界中生成和使用数据的地方,5G、边缘计算和计算机视觉等领先技术可以使企业跨运营站点实现应用程序现代化并有助于提高客户体验、运营效率和生产力。」

以下是来自半导体领域领先和新兴供应商的五种用于边缘 AI 应用的炫酷芯片解决方案:AMD、Axelera AI、英特尔、Nvidia 和 SiMa.ai。

AMD

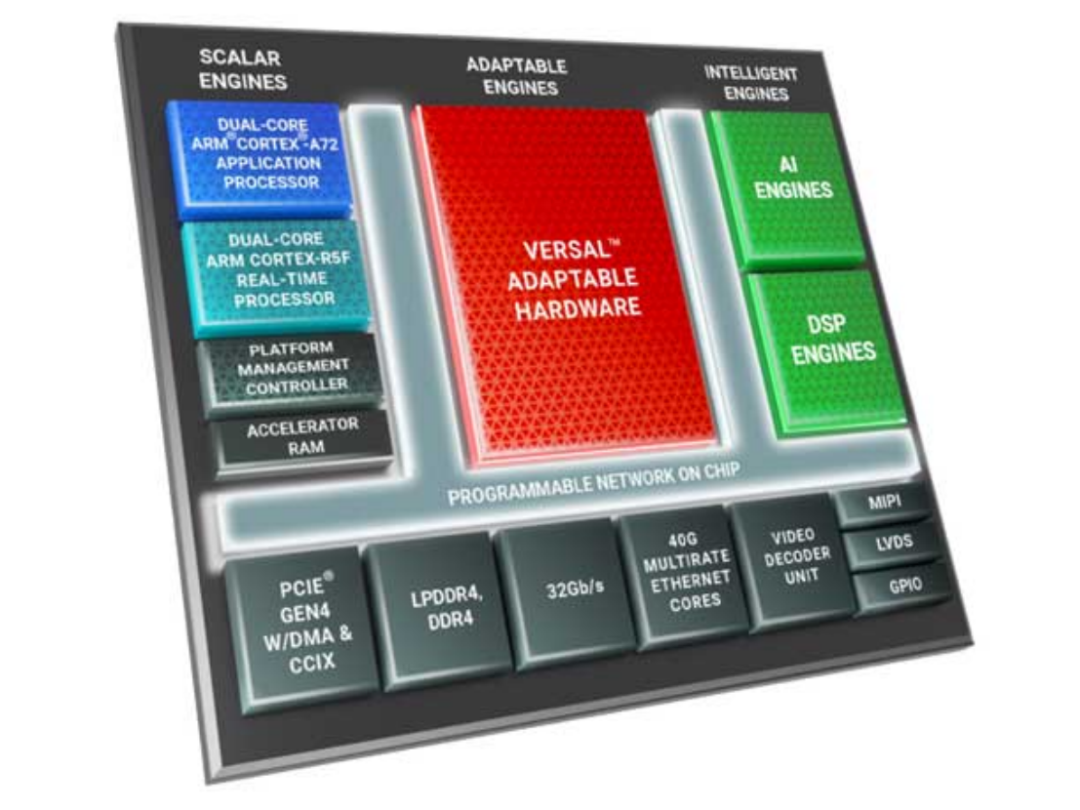

AMD 正在通过 Versal AI Edge 片上系统抓住边缘 AI 机遇,该系统旨在为自动驾驶汽车、医疗保健系统、工厂和飞机的实时系统提供与 GPU 相比具有竞争力的每瓦性能。

该芯片由三个主要部分组成:标量引擎,包括两个双核 Arm 处理器,用于运行 Linux 级应用程序和安全关键代码;具有确定性和并行性的适应性引擎,用于处理来自传感器的数据;以及可以运行通用程序的智能引擎。边缘工作负载,例如人工智能推理、图像处理和运动控制。

开发人员可以使用 AMD 的 Vitis 统一软件平台来利用 Versal AI Edge 芯片,该平台附带开源库、模型库、用于在所有 AMD 芯片架构上开发应用程序的单一编程模型以及视频分析软件开发套件。

Axelera AI

Axelera AI 通过新颖的芯片架构实现边缘人工智能应用,该架构利用了初创公司专有的内存计算和 RISC-V 控制数据流技术。

通过使用内存计算,Axelera 可以将 Metis AIPU 上 SRAM 内存的每个存储单元视为一个计算元素,从而减少在不同位置之间移动数据的需要,并从根本上增加每个计算周期的操作数量。AIPU 有两种外形尺寸:具有单个 MIPU 的 M.2 加速器模块和具有一个或四个 MIPU 的 PCIe 加速器卡。

AIPU 可以提供每核每秒超过 50 兆兆次运算、每瓦 15 TOP 以及相当于单精度浮点格式(也称为 FP32)的推理模型精度。

开发人员可以使用初创公司 Voyager 软件开发套件来利用 Axcelera 的 Metis AIPU,该套件附带运行边缘 AI 应用程序所需的多个组件,例如运行时、推理服务器、编译器和优化软件。

英特尔

英特尔通过各种芯片支持边缘人工智能应用,这要归功于其 OpenVINO 软件工具包,该工具包优化了深度学习模型以在 CPU 和 GPU 上运行。

OpenVINO 支持的处理器包括 Intel Celeron 6305E CPU,它具有两个内核、1.8 GHz 的基本频率和 15 瓦功率范围内的集成显卡。

仅使用 Celeron 的集成显卡,该芯片在 yolo_v8n 模型中就可以达到每秒 111.95 帧的速度,用于使用 8 位数字格式进行物体检测和图像分类。

开发人员可以利用 OpenVINO 将赛扬 6305E 和其他英特尔处理器用于边缘 AI 应用,OpenVINO 可以自动为给定任务选择最佳处理器,并在多个处理器之间分配推理工作负载。

英伟达

Nvidia 为边缘 AI 用例提供了多种芯片解决方案,其中包括 Jetson Orin Nano 系列,该系列在信用卡大小的片上系统中每秒执行高达 40 兆次运算 (TOPS)。

Jetson Orin Nano 的尺寸为 69.6 毫米宽、45 毫米高,采用 Ampere 架构 GPU,具有 1,024 个 CUDA 核心和 32 个 Tensor 核心,加上 6 核 Arm Cortex-A78E CPU 和 8GB LPDDR5 内存。这仅需要 7 瓦至 15 瓦的功率范围。

除了提供 40 TOPS 的 AI 推理性能外,该芯片还可以支持每 1 到 2 个 CPU 核心最多两个以 30 帧/秒、4K 分辨率运行的视频编码流。在视频解码方面,该芯片可支持每秒 1 路 60 帧的 4K 视频流、2 路 30 帧的 4K 视频流、5 路 60 帧的 1080p 流以及 11 路 30 帧的 1080p 流。

开发人员可以使用 Nvidia 的 Jetson 软件堆栈来利用 Jetson Orin Nano 芯片,其中包括用于 AI 推理的 TensorRT 和 cuDNN 等软件库、容器运行时、Linux 内核以及用于构建 GPU 加速应用程序的 CUDA 工具包。

SiMa.a

SiMa.ai 专注于通过其以软件为中心的专用 MLSoC 芯片为边缘提供高效节能的机器学习芯片解决方案。

MLSoC 配备了用于机器学习加速器的专用处理器和高性能应用处理器以及用于图像预处理和后处理的计算机视觉处理器。

这些元件使 MLSoC 能够为机器学习提供高达 50 兆兆次操作 (TOPS) 和每瓦 10 TOPS,在 4K 分辨率下视频编码高达每秒 30 帧,在 4K 分辨率下高达每秒 60 帧。视频解码分辨率和计算机视觉每秒高达 600 次 16 位千兆位运算。

开发人员可以使用 SiMa.ai 的 Palette 低代码集成开发环境来利用 MLSoC,该环境能够编译和评估任何机器学习模型以及在芯片上部署和管理应用程序。

评论